v1.21.1 版本发布

缺陷修复(Bugfix)

- 修复 v1.21.0 版本全新安装过程中安装失败的问题。

本次版本更新聚焦于「LLM 可观测」模块,以下若无特殊说明,均为「LLM 可观测」相关功能。

Lighthouse 的「LLM 可观测」模块,正式推出「自动评估」、「数据集与实验」、「Prompt 调试」三大功能。

Lighthouse 的 LLM 可观测模块的自动评估功能,是基于评估器(Evaluator)实现的。通过评估器,可以配置评估的目标数据、评估模型、评估维度,按照设定的规则,对目标数据进行自动给出合适的评分值。有效解决了人工评估效率低、准确性不足的问题。帮助企业在开发和优化 LLM 应用过程中精准定位需求,快速调整策略,从而加速产品迭代,确保应用的性能和功能符合业务目标。

目前,Lighthouse 支持对应用的 Trace 数据、数据集进行自动评估。同时,系统内置了多种常用的评估维度模板,提高用户上手速度。

「数据集」指的是一组用于评估大模型在��特定任务上的输出表现,这些数据集通常包含一系列的输入内容(Input)和输出参考答案(Reference Output)。其作用是帮助开发者评估 LLM 应用,是否达到预期效果。

基于数据集,便可以进行「实验」。实验是指,通过组合数据集、Prompt、模型设置、评估器(可选),实现在给定的 Prompt 下,对模型输入范例的 Input 内容,得到模型返回的 Output 内容。若配置了评估器,还会对每条数据进行评估,并给出评分值。通过分析实验结果,可以找到优化 LLM 应用效果的方向,获得有助于业务决策的信息。

在开发 LLM 应用的过程中,高质量的提示词(Prompt)是至关重要的一环。Prompt 内容和模型的合理搭配,可以最大限度地激发模型的潜能,满足多样化、个性化的应用场景。

Lighthouse 的「Prompt 调试」功能,可以让您无需切换工具或编写代码,便可轻松调试和优化您的 Prompt。通过调整 Prompt 内容和模型设置,可以实时查看不同模型对不同 Prompt 变更的响应,从而快速找到优化方向,极大提高工作效率。

Lighthouse 的「LLM 应用」模块,正式推出「人工评估」、「Prompt 管理」两大功能。

不同的 LLM 应用 ,有不同的业务目标,企业通常根据 LLM 应用的 input 和 output 内容来判断模型输出效果是否符合预期。Lighthouse 的人工评估功能,可以自定义评估维度(如准确性、简洁性、安全性等),并对每条 Trace、Span 数据进行多维度评分。帮助开发团队深入了解模型表现、识别问题、并持续优化模型质量,确保企业推出真正符合业务目标的优质 LLM 应用。

在开发 LLM 应用时,提示词版本混乱、缺乏效果追踪、缺少数据回溯、团队协作困难等问题,会拉低调试 Prompt 的工作效率。Lighthouse 的 Prompt 管理功能,提供 Prompt 的集中式存储库,可以对 Prompt 进行版本控制、数据对比、高效维护,显著提升 LLM 应用的质量及开发效率。

注意:从

1.17.0及之前的版本,直接升级到1.18.0及以上版本,需要提前手动清空所有数据才可正常使用。如遇此情况,请联系技术支持。

Lighthouse explores LLM application observability and officially launches the "LLM Applications" module, aiming to help enterprises monitor LLM application performance, identify performance bottlenecks, and optimize resource utilization.

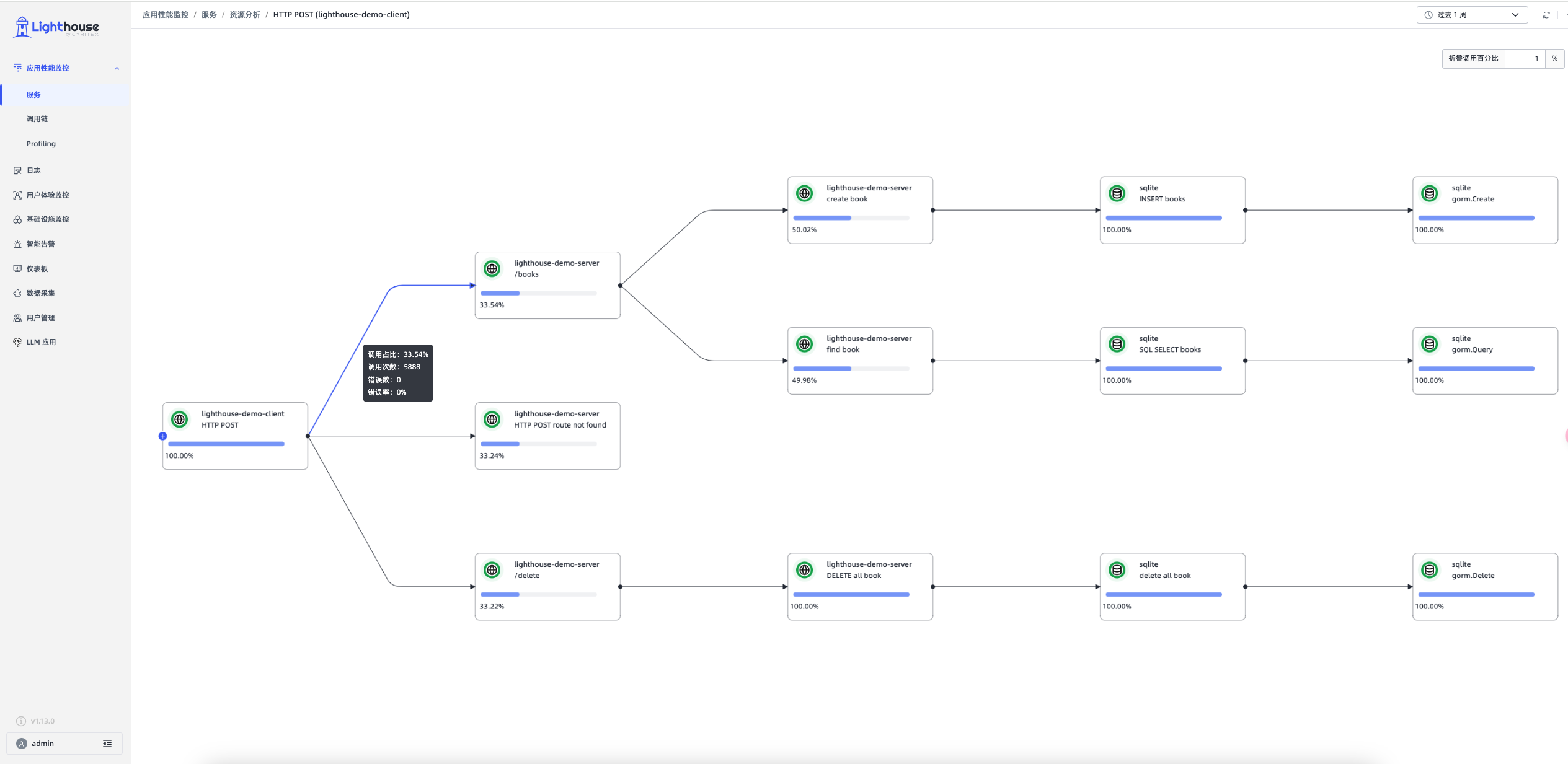

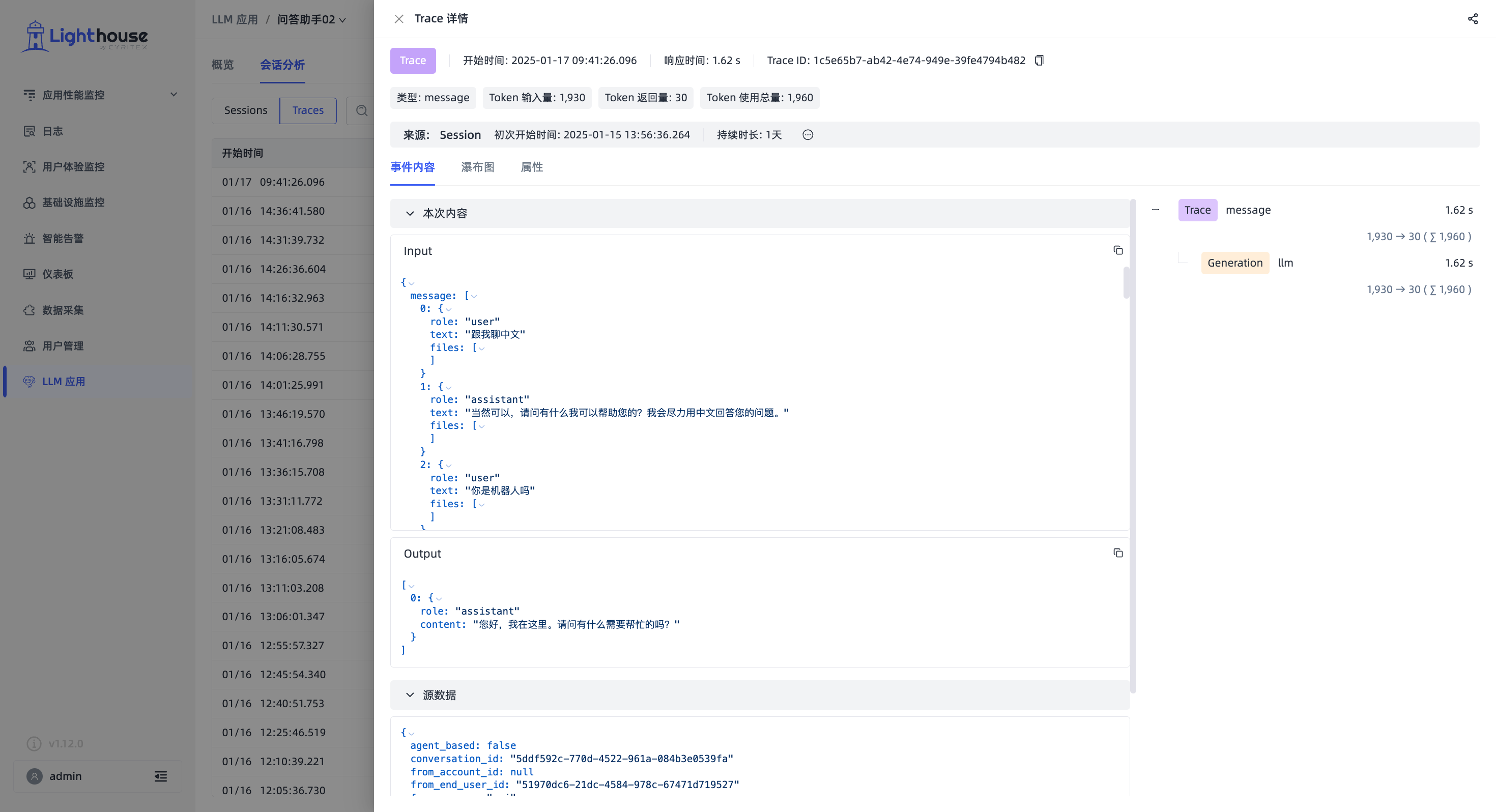

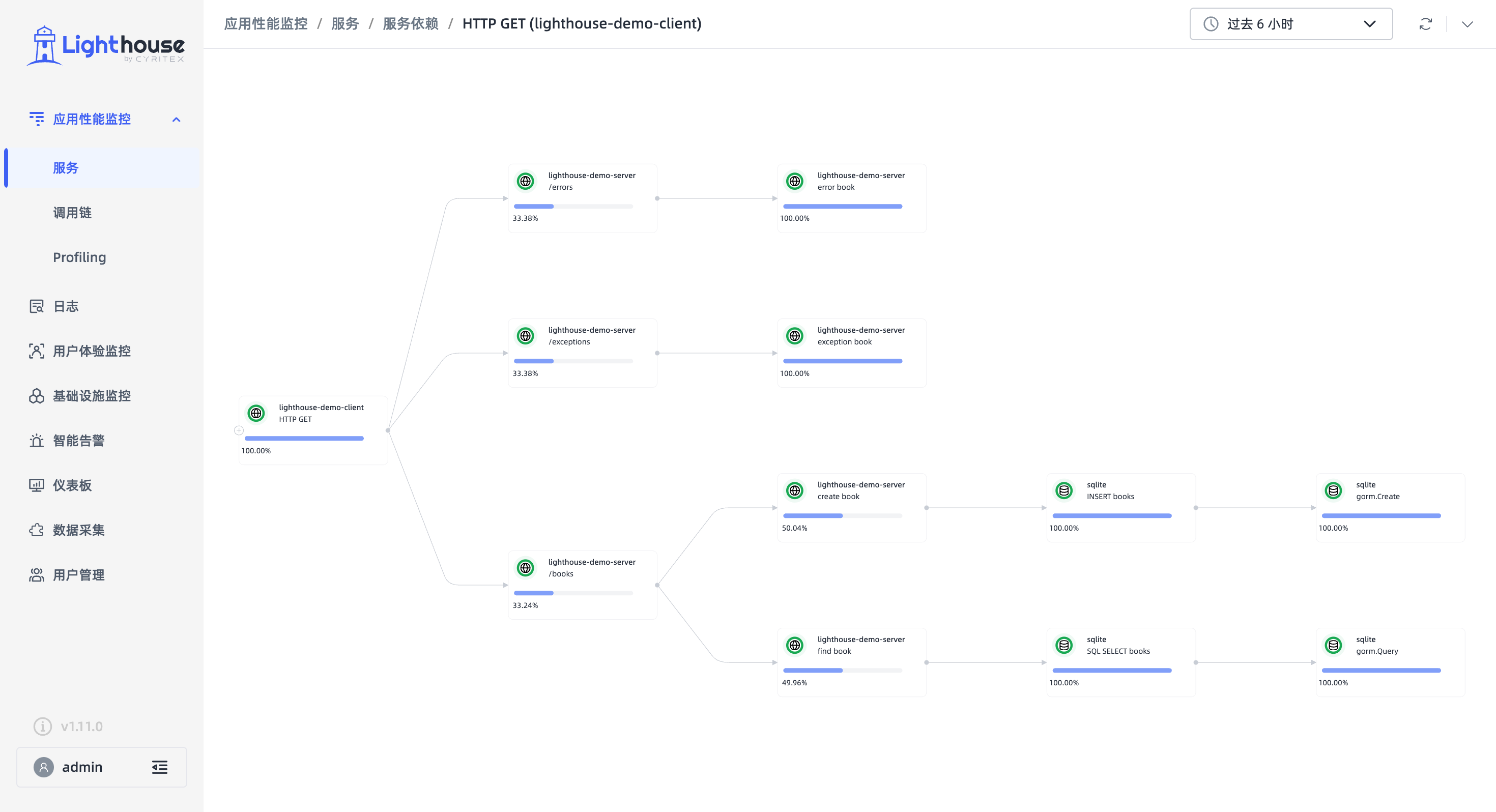

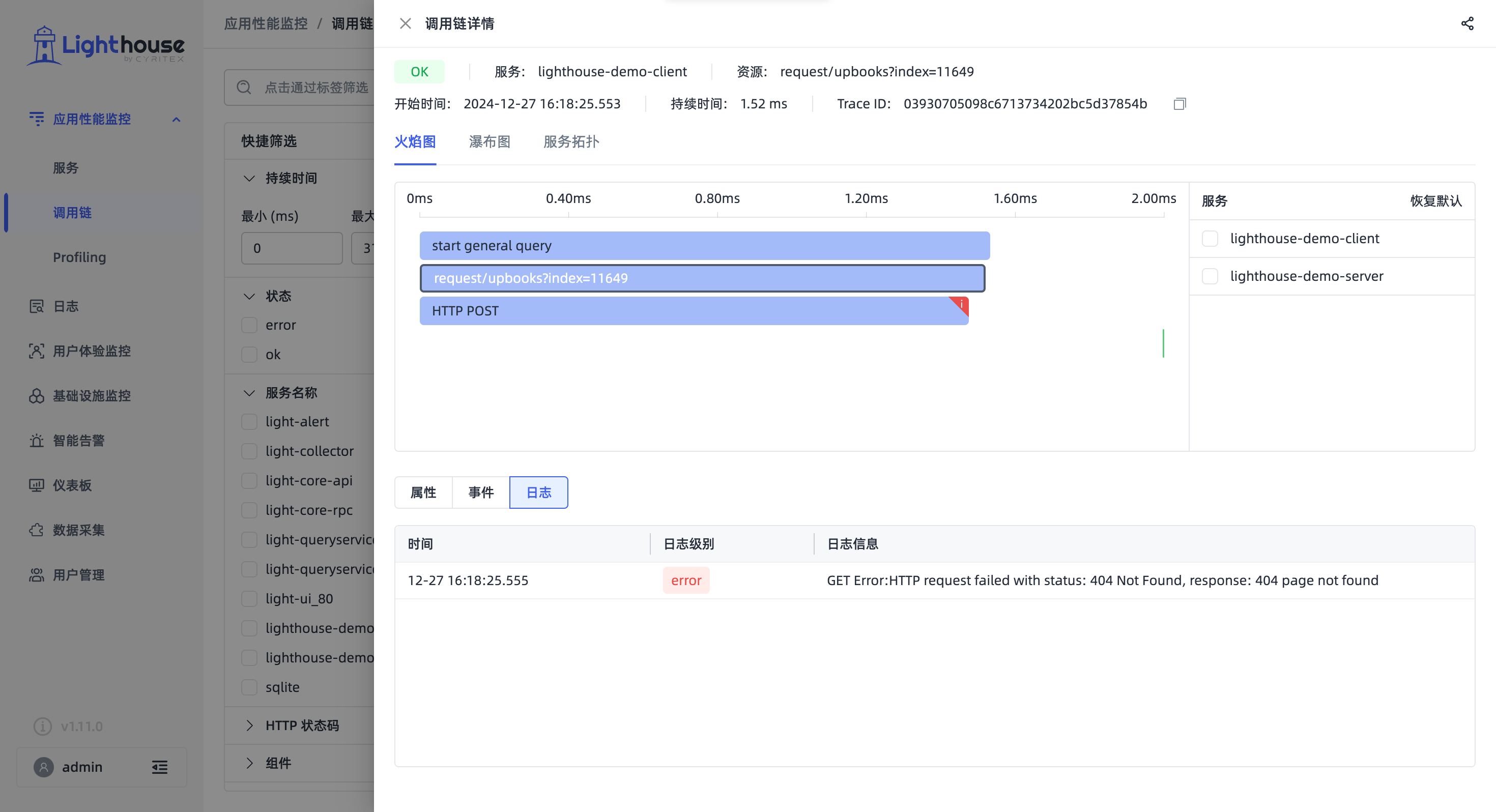

Currently, Lighthouse can observe performance data and usage of LLM applications in the system at Session and Trace dimensions, such as input, output, response time, token consumption, etc.

|  |

|---|

Fixed an issue where host statistics for infrastructure monitoring were failing.

|  |

|---|